Wechselbeziehung zwischen Kulturgeographie und Internet

| Magisterarbeit: Wechselbeziehung zwischen Kulturgeographie und Internet |

|

In Kapitel 2, das die technischen Grundlagen des Internet behandelte, wurde als Charakteristikum des

Internet unter anderem die Nutzung des TCP/IP Protokolls zur Datenübertragung erwähnt. Wenn man die

Arbeitsweise eines solchen Protokolls näher betrachtet, kann man den Inhalt des folgenden Kapitels, bei

dem es um die physisch-räumlichen Komponenten des Internet geht, klar abgrenzen. Einen Standard für den

Aufbau und die Arbeitsweise von Datenübertragungsprotokollen stellt das ISO-OSI Referenzmodell

dar. Ausgearbeitet von der International Standards Organization (ISO) ist darin der

Standard für eine Verbindung zwischen offenen Kommunikationssystemen (Open Systems

Interconnection - OSI ) beschrieben.

Tabelle 4.1: ISO-OSI Referenzmodell (TANENBAUM, 1998, S. 45ff.). |

||||||||||||||||||||||||

|

Bei der Übertragung von Daten wird das Protokoll (siehe Tabelle 4.1.) theoretisch zunächst

von Schicht 7 bis Schicht 1 abgearbeitet, die Daten werden dabei in physikalisch

übertragbare Signale (0 und 1) umgewandelt und an den Zielrechner verschickt. Dort erfolgt in

umgekehrter Reihenfolge von Schicht 1 bis Schicht 7 die Rückführung der empfangenen Signale in die

ursprüngliche Datenstruktur. Das Übertragungsprotokoll ermöglicht so eine Kommunikation zwischen zwei

vernetzten Geräten, ohne dass sich die Anwendungen um die Prozeduren der eigentlichen Datenübertragung

kümmern müssen. Die Verbindung zwischen den Anwendungen, die auf den Hosts betrieben werden, wird als

virtuelle Verbindung bezeichnet, im Gegensatz zur physikalischen Verbindung, die durch die

Übertragungsmedien besteht.

|

||||||||||||||||||||||||

| Im Folgenden soll es ausschließlich um die Bitübertragungsschicht (Schicht 1), also die physikalische Verbindung gehen. Hierbei wird unterschieden zwischen der physischen Infrastruktur, die alle Übertragungsmedien und deren räumliche Verbreitung umfasst und den durch diese Medien geleiteten Datenströmen, sowie deren Umfang und Verbreitung. |

|

Einem Artikel über die Nutzung des Internet in Afrika gab die Süddeutsche Zeitung den Titel: Wo kein

Telefon, da kein Internet (SÜDDEUTSCHE ZEITUNG, 6.1.2000). Wenn man das Telefon als Einstiegsgerät

für die Nutzung technischer Kommunikationsmittel sieht, kann man dieser Aussage in gewissem Maß

zustimmen. Tatsache ist jedoch, dass beim momentanen Stand der Übertragungstechnik der Telefonanschluss

keine notwendige Bedingung mehr für einen Zugang zum Internet ist. Als limitierender Faktor fallen dabei

stärker die Kosten für Hardware-Ausstattung und Nutzungsgebühren anderer möglicher Übertragungswege, die

nicht an herkömmliche Telefonleitungen gebunden sind, ins Gewicht. Die vielfältigen Übertragungsmedien

für Internetdaten sollen im Folgenden zunächst im Überblick dargestellt und danach ihre Verfügbarkeit im

globalen und lokalen Maßstab untersucht werden.

|

||||||||||||||||||||||||||||

Zunächst sollen die existierenden Übertragungsmedien betrachtet werden. Die physische Infrastruktur des

Internet kann in einem ersten Schritt grob in terrestrische und aerische Medien unterteilt werden.

Terrestrische Übertragungsmedien basieren auf Kupferkabeln oder Lichtwellenleitern, aerische Medien auf

der Übertragung per Funk oder Laserstrahlen (siehe Tabelle 4.2).

Tabelle 4.2.: Datenübertragungsmedien (TANENBAUM, 1998, S. 102ff.). |

||||||||||||||||||||||||||||

Während es bei terrestrischen Medien notwendig ist, dass die Strecke vom Sender zum Empfänger über ein

durchgehendes Netz von Übertragungsleitungen verbunden ist, so sind beim punktuell ausgerichteten

Übertragungssystem aerischer Medien Empfangseinrichtungen beim Sender und Empfänger notwendig, die

lediglich mit dem zur Datenverarbeitung genutzten Endgerät verbunden sind. In der Praxis existieren

Mischformen beider Technologien, so kann zum Beispiel für den Empfang von Daten eine

Satellitenverbindung aufgebaut werden, wogegen beim Senden auf eine terrestrische Verbindung via

Telefonnetz zurückgegriffen wird. Auch die Infrastruktur des Internet im Speziellen stellt eine

Mischform aus terrestrischen und aerischen Verbindungen dar. Wenn es um die räumliche Verbreitung dieser

Infrastruktur geht, liegt es bei einer geographischen Betrachtung nahe, die Situation anhand einer

kartographischen Übersicht darzustellen. Aufgrund der komplexen Struktur der Übertragungsmedien des

Internet ist es notwendig, wie zum Beispiel auch bei der Darstellung von Flugverkehrsrouten oder

Handelsströmen, je nach betrachtetem Maßstab durch Selektion oder Bündelung der dargestellten

Komponenten, Übersichtlichkeit zu gewährleisten und das Ziel der Darstellung deutlich zu machen. In der

frühen Phase des Internet war es aufgrund der geringen Zahl angeschlossener Rechner noch möglich, die

Infrastruktur umfassend darzustellen.

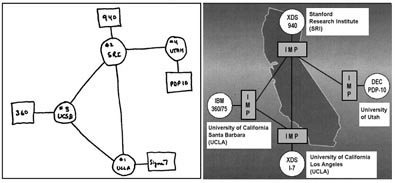

Abbildung 4.1.: ARPANET Ende 1969 (linke Abbildung: THE COMPUTER MUSEUM HISTORY CENTER, 1997a; rechte Abbildung: BORCHERS u.a., 1999, S. 130). Abbildung 4.1 zeigt den Ursprung des ARPANET im Jahre 1969. Die beiden Beispiele machen deutlich, dass es unterschiedliche Methoden gibt, die Internet-Infrastruktur darzustellen: Während in der linken Bildhälfte die Struktur und die angeschlossenen technischen Geräte von Interesse sind, zeigt die rechte bereits die Einbeziehung des geographischen Kontextes, indem zur Orientierung die technische Struktur mit dem Umriss Kaliforniens unterlegt wird. Es lohnt sich an dieser Stelle einen generellen Blick auf die kartographischen Darstellungsmöglichkeiten des Internet zu werfen, bzw. einige Begriffe zu klären. Die Überschrift eines Artikels in der Geographischen Rundschau lautete Webmapping: Kartenpräsentation im World Wide Web (DICKMANN, 2000). In diesem Zusammenhang ist es etwas irreführend, den Begriff webmapping zu verwenden, da es nur darum geht, das Medium zu beschreiben, mit dem man seine Karten präsentiert. Üblicherweise erwartet man, dass die kartierten Inhalte durch den Zusatz zum Wort Kartierung näher beschrieben werden. Zum Beispiel versteht man unter einer Schrebergartenkartierung in der Regel nicht die Präsentation der Arbeit in einem solchen, sondern eine inhaltliche Übereinstimmung. Man sollte den Begriff der Webkartographie oder auch die englische Version des webmapping deswegen nur dann verwenden, wenn es tatsächlich darum geht, Aspekte des WWW kartographisch darzustellen. Dasselbe gilt für den Begriff der Internetkartographie. |

||||||||||||||||||||||||||||

Eine sehr gute Übersicht über die Möglichkeiten, das Internet kartographisch darzustellen, findet sich

in Martin Dodge's Atlas of Cyberspaces (http://""www.cybergeography.org). Tabelle 4.3 zeigt, in

welche Kategorien die Darstellungen unterteilt werden. Grundsätzlich kann man vier Darstellungsformen

unterscheiden:

Tabelle 4.3: Kategorien des internetmapping und die dargestellten Inhalte, basierend auf der Einteilung Martin Dodges in: An Atlas of Cyberspaces (http://www.cybergeography.org/atlas/). |

||||||||||||||||||||||||||||

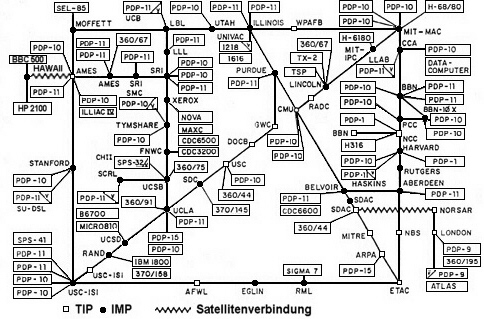

Kehren wir zurück zur konkreten Darstellung der physischen Infrastruktur des Internet. Wir waren

stehengeblieben bei Abbildung 4.1, der Frühform des ARPANET aus dem Jahr 1969. Festgehalten wurde, dass

aufgrund der geringen Anzahl angeschlossener Hostrechner eine vollständige Darstellung möglich war. Das

schnelle Wachstum des Internet führte dazu, dass diese Übersichtlichkeit in Darstellungen nicht lange

beibehalten werden konnte. Vor allem als sich das Internet über die nationalen Grenzen der USA

hinaus entwickelte und neben den herkömmlichen terrestrischen Verbindungen weitere Übertragungsmedien

hinzukamen, wurde eine vollständige Darstellung immer schwieriger. Abbildung 4.2 (Seite 61) zeigt den

Entwicklungsstand des ARPANET im Jahr 1975. Im Vergleich zum Stand von 1969 konnte sich das Netz

in nur sechs Jahren im gesamten US-amerikanischen Raum verbreiten. Per Satellitenübermittlung war eine

erste Anbindung europäischer Rechner möglich.

Abbildung 4.2: ARPANET Januar 1975 (THE COMPUTER MUSEUM HISTORY CENTER, 1997b, überarbeitete Fassung). |

||||||||||||||||||||||||||||

|

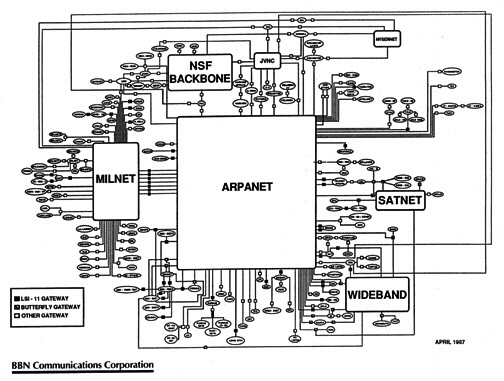

Neben dem ARPANET waren im Verlauf der 1970er und 80er Jahre immer mehr unabhängige Netze entstanden.

Man konnte nun vom Internet als Netz der Netze sprechen, da eine Verbindung zwischen den

einzelnen Netzen bestand. Für die Darstellung des Internet war es nun notwendig geworden,

unterschiedliche Aspekte der Netzarchitektur hervorzuheben. Eine Möglichkeit bestand darin, statt der an

das einzelne Netz angeschlossenen Hardware die Struktur der Netze in ihrer

Gesamtheit zu betrachten. Abbildung 4.3 (Seite 62) zeigt den Entwicklungsstand des Internet

im Jahr 1983 in einer solchen schematischen Übersicht.

Betont werden in dieser Abbildung nicht mehr die technischen Komponenten des Internet, sondern die unterschiedlichen Ausprägungen der einzelnen Netze. So werden zum Beispiel nach dem verwendeten Übertragungsmedium satellitengestützte und Funknetzwerke unterschieden. Der Aspekt der Reichweite und die Nutzungsart führt zur Unterteilung in Local Area Networks (LANs) und dem ARPANET verwandte Typen. Kommerzielle Netzwerke werden einzig durch ihren Verwendungszweck charakterisiert. Ziel dieser Darstellung ist, die Strukturen, die sich bei der Vernetzung der einzelnen Netze herausgebildet haben, zu erfassen. Sie zeigt, dass ARPANET, WIDEBAND NET und SATNET zu drei Kernpunkten geworden sind, die als Anknüpfungspunkte für weitere Netze dienen. Noch deutlicher wird diese Funktion in Abbildung 4.4 (Seite 63). Als neuer zentraler Punkt ist das MILNET zu erkennen, das 1983 vom ARPANET abgespaltet wurde, um speziell für militärische Zwecke genutzt zu werden, sowie das Netz der National Science Foundation (NSF), das ausschließlich wissenschaftlichen Kreisen zugänglich war.

Figure 4.4: Das Internet 1987 (THE COMPUTER MUSEUM HISTORY, 1997c). |

||||||||||||||||||||||||||||

Betrachten wir also, wie sich der Internetzugang für den Heimanwender gestaltet: Die Ausgangssituation

stellt sich im Vergleich zum Verkehrsnetz etwas anders dar, da der Benutzer bereits von Anfang an auf

das gesamte Spektrum der Übertragungsmöglichkeiten, vergleichbar den unterschiedlichen Verkehrsmitteln,

zugreifen kann: Der klassische Weg verläuft über die Telefonleitung (analog oder digital), wahlweise

aber auch über Satellit bzw. Funk und, bisher erst in eingeschränkter Form, über das Strom- oder

Kabelfernsehnetz (HAJNAL, 1999). Unabhängig von der Art der Datenübermittlung ist der erste Schritt, um

Zugang zum Internet zu bekommen, die Verbindung mit einem Internet Service Provider (ISP).

Übertragen auf das Modell des Verkehrsnetzes kann diese Aktion mit dem Verlassen des Hauses und der

Nutzung eines Fortbewegungsmittels verglichen werden. Die Bandbreiten, die bei der Verbindung zum ISP

möglich sind, bewegen sich zwischen 56 kbps bei einem analogen Telefonanschluss, bis hin

zu mehreren tausend kbps bei Satelliten- oder Funkübertragung. Tabelle 4.4 zeigt zur zahlenmäßigen

Orientierung eine Übersicht ausgewählter Übertragungsmedien, die vom Heimanwender genutzt werden können,

sowie die zugehörigen Bandbreiten. Es handelt sich hierbei um theoretische Maximalwerte, die in der

Praxis nicht immer erreicht werden.

Tabelle 4.4: Bandbreiten der primären Übertragungsmedien. |

||||||||||||||||||||||||||||

Hat man sich beim ISP eingewählt, hängt die weitere Datenübermittlung von der Infrastruktur des

ISP-Netzes ab. Einige ISP-Netze sind direkt mit der nächst höheren Ebene, dem nationalen Backbone,

verbunden. In Staaten mit großer geographischer Ausdehnung, wie zum Beispiel in den USA oder Russland,

existieren dagegen als Zwischenstufe sogenannte regionale Netzwerke, die das Datenaufkommen der

Privatanwender ein erstes Mal bündeln und über Verbindungen mit entsprechend höherer Bandbreite an das

nationale Netz weiterleiten. Übertragen auf das Beispiel der Verkehrswege kann man die Ebene der

regionalen Netze mit dem deutschen Bundesstraßennetz vergleichen, wogegen der nationale Backbone dem

Autobahnnetz entspricht. In Deutschland mit seinen vergleichsweise geringen räumlichen Ausdehnungen

sind die ISP meist direkt auf nationaler Ebene vertreten und besitzen in der Regel eine eigene

Anbindung an das internationale Netz. Abbildung 4.5 zeigt den nationalen Backbone des deutschen

Providers Nikoma. Bei dieser Darstellung handelt es sich nicht mehr um eine ausschließlich an den

technischen Komponenten orientierte Graphik, sondern um eine Verbindung von Netzarchitektur und der

geographischen Verbreitung. Dabei zeigen sich große Unterschiede in der Anbindung an das Backbone-Netz.

Auf der Karte ist zu erkennen, dass einzelne Gebiete in Deutschland, unter anderem der Südwesten, von

einer direkten Backbone-Anbindung räumlich weit entfernt sind. Dies lässt sich nicht nur beim

Provider Nikoma feststellen, sondern findet sich auch beim ISP Mobilcom. An diesem Beispiel wird

deutlich, dass in Deutschland zwar aufgrund des in der Fachsprache als Plain Old Telephone

System (POTS) bezeichneten Telefonnetzes für Privatanwender ein flächendeckender

Internetzugang möglich ist, wenn es aber um Zugänge für Business-Anwendungen geht, die unter

Umständen auf eine hohe Bandbreite angewiesen sind, sich aufgrund der Internet-Infrastruktur für

einzelne Gebiete mit direkter Backbone-Anbindung Standortvorteile ergeben. Ergänzend zeigt Abbildung

4.6 den Backbone der Internet Initiative Japan (IIJ) als schematische Darstellung, bei

der noch einmal die technischen Daten im Vordergrund stehen. Besonders deutlich kann man in

diesem Fall die unterschiedlichen Bandbreiten der einzelnen Netzabschnitte ablesen.

Abbildung 4.5: Backbone des ISP Nikoma (NIKOMA, 2000).

Abbildung 4.6: Backbone der Internet Initiative Japan (IIJ) ( IIJ, 2000). Damit eine Kommunikation zwischen den Netzen unterschiedlicher Ebenen möglich ist, dienen sogenannte Network Access Points (NAPs) als Vermittlungsstellen zwischen den einzelnen Backbone-Netzen. NAPs entstanden 1993, als in den USA der bisher staatlich finanzierte Backbone des NSFNET 1993 privatisiert und durch eine Vielzahl kommerzieller Backbone Netze ersetzt wurde. Mit Hilfe der NAPs und der dabei angewandten switching-Technologie können Datenpakete von einem Netz in ein anderes weitergeleitet werden. Sowohl das Backbone-Netz des deutschen ISP Nikoma, als auch der Backbone der IIJ sind mit den NAPs in den USA verbunden, wie Abbildung 4.5 und 4.6 zeigen. Auch in Europa sind Internet Exchange Points, vergleichbar den NAPs, entstanden, nachdem europäische Netzwerke aufgrund des steigenden Datenaufkommens nicht mehr ausschließlich auf die Backbone-Infrastruktur der USA zugreifen konnten. Abbildung 4.7 zeigt die Verbreitung europäischer Exchange Points (EP). Obwohl die Karte längst nicht alle Punkte zeigt im Rahmen dieser Arbeit wurde auf die vorhandenen Daten der Exchange Point Information (http://www.ep.net) zurückgegriffen, ergibt sich ein Muster, nach dem sich EPs zunächst in den Hauptstädten ansiedeln und dann innerhalb der einzelnen Länder auf Standorte ausweiten, die als Zentren im Finanzmarkt oder als Medienstandorte gelten. Dieses Verteilungsprinzip tritt besonders in Deutschland in Erscheinung, wo allein in München drei EPs registriert sind. Es sei noch einmal betont, dass diese Darstellung keinen Anspruch auf Vollständigkeit erhebt. Da es keine zentrale Registrierungsstelle gibt, hätte es den zeitlichen Rahmen dieser Arbeit gesprengt, alle weiteren EPs zu ermitteln.

Abbildung 4.7: Internet Exchange Points Europa (eigene Darstellung, Datenquelle: Exchange Information http://www.ep.net). Damit sind wir fast am Ende dieses Unterkapitels angelangt. Abschließend soll auf eine Arbeit verwiesen werden, die sich mit den statistischen Methoden im Speziellen auseinandersetzt, mit Hilfe derer die Infrastruktur des Internet analysiert werden kann. Sean GORMAN (1998) schreibt in seinem Artikel The Death of Distance but not the End of Geography: The Internet as a Network, welche Schritte notwendig sind, um die Struktur der Internet-Infrastruktur in geographischer Weise zu analysieren. Er greift dabei auf Datensätze der Cooperative Association for Internet Data Analysis (CAIDA) zurück und entwickelt aus Städten als Knotenpunkten und Glasfaserleitungen als Verbindungen zwischen diesen Knotenpunkten eine Matrix, die er mit Hilfe statistischer Methoden auswertet. Bei der Analyse eines beliebigen Netzes legt Gorman zunächst fest, welche Knotenpunkte zu statistischen Einheiten zusammengefasst werden sollen: Sogenannte Consolidated Metropolitan Statistical Areas (CMSAs) zeichnen sich zum Beispiel dadurch aus, dass sie von einem Glasfaserring umschlossen sind, der eine schnelle Weiterleitung des hohen städtischen Datenaufkommens ermöglicht. Nimmt man die Anzahl der Verbindungen hinzu, die zwischen diesen CMSAs bestehen, kann man Maße, wie die Größe eines Netzwerkes (Anzahl der Verbindungen abzüglich Anzahl der CMSAs) oder die Komplexität eines Netzwerkes (Anzahl der Verbindungen pro CMSA) errechnen. Weitere Möglichkeiten zur Strukturierung der Netzwerke stellt die sogenannte binary connectivity matrix dar, bei der CMSAs darauf untersucht werden, zu welchen anderen CMSAs eine Verbindung besteht, bzw. zu welchen nicht. Für die USA ermittelt Gorman als Spitzenreiter der binären Verbindungsanalyse Chicago mit circa 58 Verbindungen im Jahr 1998, gefolgt von San Francisco und Washington D.C., mit je 55 Verbindungen. Chicago nimmt damit eine zentrale Position innerhalb des Netzwerkes der USA ein, was Gorman mit der zentralen nationalen Lage begründet. Chicago wird damit zu einem wichtigen Knotenpunkt für den Austausch zwischen den restlichen Punkten. Um die unterschiedliche technische Ausstattung der Verbindungen zu berücksichtigen, kann anstatt der binären Verbindungsanalyse die zur Verfügung stehende Bandbreite pro CMSA als Variable genutzt werden. In Gormans Beispiel der USA steht in diesem Fall nicht mehr Chicago an erster Stelle, sondern fällt auf den dritten Platz hinter Washington D.C. und San Francisco zurück. Gorman stellt fest, dass die technologische Ausstattung der CMSAs stark von deren bisheriger Stellung im wirtschaftlichen und politischen System abhängt und somit die existierenden nationalen Dispariäten widerspiegelt. Dieses Beispiel zeigt, dass eine kulturgeographische Analyse der Infrastruktur des Internet sowohl auf einer Betrachtung rein technischer Faktoren beruhen kann, aber auch unter Einbeziehung bestehender kulturgeographischer Themenbereiche, wie zum Beispiel der Wirtschaftsgeographie, stattfinden kann. |

||||||||||||||||||||||||||||

|

Abschließend bleibt festzuhalten, dass der Einblick in die Möglichkeiten der geographisch

darstellbaren und analysierbaren Themenbereiche der Internet-Infrastruktur in diesem Kapitel

keinesfalls dem Anspruch einer vollständigen Übersicht gerecht werden kann. Da Nicht-Informatiker

einige Zeit benötigen, um sich in die technischen Abläufe der Datenübertragung einzuarbeiten,

und es bisher nur wenig Material zu spezifisch geographischen Fragestellungen in Bezug auf die

Infrastruktur des Internet gibt, ist eine intensivere Beschäftigung mit diesem Thema im Rahmen dieser

Arbeit nicht möglich. Weiterführende Arbeiten sollten in jeden Fall die Möglichkeiten kabelloser

Übertragungsmedien eingehend erörtern und der Frage nachgehen, wie es um die Möglichkeiten einer

gänzlich kabellosen Datenübertragung steht, die zum Beispiel durch die Nutzung von Solarenergie auch

von einem Stromnetz unabhängig wären. Dieser Ansatz ist für die Frage globaler Zugangsmöglichkeiten

von Bedeutung, denn es steht außer Frage, dass die Anbindung bisher nicht vernetzter Gebiete der Erde

in Zukunft vorwiegend über kabellose Übertragungsmedien stattfinden wird, da es finanziell und

technisch nicht möglich ist, jeden beliebigen Ort der Welt über ein Kabelnetz mit dem Internet zu

verbinden.

|

||||||||||||||||||||||||||||

| Festzuhalten bleibt ebenfalls, dass die physische Infrastruktur des Internet ein weites Feld für geographische Untersuchungen bietet. Dem verfolgten Untersuchungsziel entsprechend kann sie entweder als technisches Strukturdiagramm oder kartographisch dargestellt werden. In Kapitel 5 wird auf diese Analyseebene noch einmal zurückzukommen sein, wenn es darum geht, die physische Infrastruktur in direkten Bezug zu kulturgeographischen Themen zu setzen. Fragen, wie etwa nach der globalen Verbreitung der Infrastruktur oder nach Zugangsdisparitäten, die durch eine lückenhafte Netzabdeckung bedingt sind, machen die Analyse dieses Bereichs für die Kulturgeographie interessant. Ähnlich verhält es sich mit dem Thema des folgenden Unterkapitels, in dem die Möglichkeiten der Messung und Darstellung der Internet-Datenströme erörtert werden. Auch hier können durch die Hinzunahme einer konkreten kulturgeographischen Fragestellung einige der auftretenden Muster erklärt werden. |

|

Nachdem im vergangenen Kapitel die Internet-Infrastruktur in ihrer rein physischen Beschaffenheit

betrachtet wurde, soll das Augenmerk jetzt auf die Daten gerichtet werden, für deren Transport diese

Übertragungsmedien geschaffen wurden. Dabei kann man zwei Vorgehensweisen unterscheiden:

1) Die Verfolgung der Wege einzelner Datenpakete, um die vom Sender zum Empfänger zurückgelegte Strecke

zu ermitteln. 2) Die Beobachtung der Gesamtmenge an Daten, die über einen bestimmten Abschnitt des

Netzes verschickt werden, zur Ermittlung besonders stark frequentierter Bereiche mit hoher Auslastung.

Für beide Ansätze sollen im Folgenden Analysemethoden und Anwendungsbeispiele vorgestellt werden.

|

||||||||||||||||||||||||||||||

|

Wichtigstes Hilfsmittel für die Ermittlung der Übertragungswege von Internetdaten sind sogenannte

Traceroute-Programme. Sie ermöglichen es, den von Datenpaketen zurückgelegten Weg vom Sender zum

Empfänger zu verfolgen. Als Orientierungspunkte dienen diesen Programmen die eingangs beschriebenen

IP-Adressen, die für jeden mit dem Internet verbundenen Rechner vergeben werden. Die Datenausgabe, sowie

die Bedienung der einzelnen Traceroute-Programme reicht von einer ausschließlich textbasierten Ein- und

Ausgabe bis hin zu graphischen Benutzeroberflächen mit der Möglichkeit, die Wege der Daten in

Karten oder 3D-Erdmodellen darzustellen. Im Folgenden soll zunächst die Arbeitsweise der Programme

erläutert und anhand ausgewählter Beispiele veranschaulicht werden. Im zweiten Schritt werden einige

charakteristische Muster des Datenaufkommens vorgestellt, die als Ergänzung zur Analyse der physischen

Infrastruktur Schlussfolgerungen über die weltweite Verbreitung des Internet zulassen.

|

||||||||||||||||||||||||||||||

Das einfachste aller Traceroute-Programme lässt sich unter Microsoft Betriebssystemen auf der DOS-Ebene

mit folgendem Befehl aufrufen:

tracert Domainname.Toplevel-DomainFür UNIX-Systeme lautet der Befehl: traceroute Domainname.Toplevel-Domain Abbildung 4.9 zeigt als Beispiel einen Durchlauf des Traceroute-Programmes für den Weg, den Datenpakete von einem Rechner in Freiburg im Breisgau aus zum WWW-Server der Universität München nehmen. Das Programm gibt als Ergebnis Informationen zur Übertragungsgeschwindigkeit der Verbindung, den Namen, sowie die IP-Adressen der Rechner aus, über die die Verbindung stattfindet. Die Arbeitsweise des Programmes basiert auf Funktionen der im Internet genutzten Datenübertragungsprotokolle (wie zum Beispiel das TCP/IP Protokoll). Jedes Übertragungsprotokoll kann mit Eigenschaften versehen werden, die den Ablauf der Datenübermittlung bestimmen. Für das Traceroute-Programm ist vor allem das sogenannte TTL-Feld (time-to-live-Feld) von Bedeutung, in dem die maximale Anzahl von Routern festlegt ist, die das Datenpaket passieren darf. Jeder Router, der das Datenpaket weiterleitet, setzt den Wert des TTL-Feldes um den Faktor 1 herunter. Ein Datenpaket mit einem TTL-Feld 1, das der Router auf den Wert 0 setzt, wird von diesem gelöscht. Mit Hilfe dieser Funktion kann verhindert werden, dass Datenpakete, die ihren Empfänger nicht erreichen können, unendlich lange im Internet zirkulieren und damit unnötig Ressourcen verbrauchen. Wird ein Datenpaket aufgrund des abgelaufenen TTL-Feldes tatsächlich vernichtet, erhält der Sender des Paketes eine Meldung, die ihn über den Verlust der Daten informiert (BLACK, 1999, S. 66). Traceroute-Programme machen sich diese Funktionalität zu nutze: Nachdem über einen DNS-Lookup die dem Domainnamen zugehörige IP-Adresse ermittelt wurde, beginnt Traceroute drei Datenpakete mit dem Wert 1 im TTL-Feld zu versenden. Um die Dauer der Übertragung zu ermitteln, wird der Zeitpunkt des Übertragungsbeginns festgehalten. Erreichen die Pakete den ersten Router, setzt dieser das TTL-Feld auf den Wert 0 und bekommt damit das Signal, die Pakete zu vernichten. Er sendet daraufhin eine Fehlermeldung an den Sender des Paketes und informiert diesen über den Abbruch der Übertragung. Zusammen mit der Fehlermeldung wird der Zeitpunkt übermittelt, an dem das Paket ursprünglich abgeschickt wurde. Traceroute muss in diesem Fall nur noch die Ankunftszeit der Fehlermeldung festhalten und kann daraus die sogenannte Round Trip Zeit (in Millisekunden) ermitteln, also die vergangene Zeit vom Senden des Paketes, über die Verarbeitung im Router, bis zum Empfang der Fehlermeldung. Diese Werte werden vom Traceroute Programm für alle drei Testpakete ausgegeben (siehe Abbildung 4.9). Damit ist der Weg zum ersten Router ermittelt, in der Programmausgabe mit der Zahl 1 in der ersten Spalte gekennzeichnet. |

||||||||||||||||||||||||||||||

|

Im nächsten Schritt versendet Traceroute drei Datenpakete, die den Wert 2 im TTL-Feld stehen haben.

Dadurch kann der eben ermittelte erste Router passiert werden, denn die Datenpakete werden erst vom

darauffolgenden Router vernichtet. Erneut wird die Round Trip Zeit ermittelt und Traceroute

versendet die nächsten Pakete mit dem TTL-Feld-Wert 3. Diese Prozedur wird so lange fortgesetzt, bis der

Rechner des Empfängers erreicht ist. Da die Prozesse des Traceroute Programmes auf dem vergleichsweise

einfachen Internet Control Message Protocol (ICMP) basieren, muss auch für diese letzte Station

eine Fehlermeldung hervorgerufen werden, um eine Rückmeldung an den Absender zu produzieren. Hierzu wird

für die port number, anhand derer Server ihnen zugedachte Datenpakete erkennen können (zum Beispiel

port 80 für WWW-Server, port 25 für E-Mail-Server) ein Wert gesetzt, der nicht als gängige port number

definiert ist. Dies verhindert den abschließenden Empfang der gesendeten Pakete, woraufhin der

Zielrechner die Fehlermeldung port unreachable ausgibt, anhand derer Traceroute die letzte Round

Trip Zeit ermitteln kann und die dem Programm mitteilt, dass die Verfolgung des Übertragungsweges

vollständig ist (RICKARD, 1998).

|

||||||||||||||||||||||||||||||

|

Im vorliegenden Beispiel (Abbildung 4.9) bewegt sich die Anfrage des Traceroute-Programmes zunächst

innerhalb des Nikoma-Netzes, das den Ausgangspunkt für die Anfrage in Freiburg darstellt. Die beiden

ersten angesprochenen Router gehören zum Knotenpunkt Stuttgart, von dem aus die Datenpakete an den

zentralen Knotenpunkt Frankfurt weitergeleitet werden. Von dort aus wird die Anfrage über

den Backbone des Deutschen Forschungsnetzes (DFN) an das Landesrechenzentrum München und den

dortigen WWW-Server der Universität München geleitet. Der Asteriskus (*) in Routerebene 8 zeigt an,

dass für dieses Datenpaket keine Rückmeldung geliefert wurde. Auf Routerebene 9 zeigt sich für das erste

Datenpaket eine vergleichsweise lange Übertragungsdauer, was auf Unregelmäßigkeiten bei der

Datenübermittlung in diesem Bereich hinweist. Das Traceroute-Programm kann somit zum einen für

die Ermittlung der zurückgelegten Übertragungsstrecke, zum anderen für einen Vergleich der

Übertragungsgeschwindigkeit herangezogen werden.

|

||||||||||||||||||||||||||||||

Ein weiteres einfaches Verfahren, um Informationen über den Weg eines Datenpaketes zu erhalten, stellt

der ping-Befehl dar, der ebenfalls sowohl für UNIX, als auch für Microsoft Betriebssysteme verfügbar

ist. Abbildung 4.10 zeigt das Ergebnis des ping-Befehls in der Bildschirmausgabe (ebenfalls am Beispiel

der Zieladresse www.uni-muenchen.de). Nach der Eingabe des Befehles werden vier Datenpakete

an die Zieladresse verschickt und für jedes Paket die durchschnittliche Übertragungszeit, ein

eventueller Verlust des Paketes, sowie der Wert des TTL-Feldes angezeigt. Aus den genannten Angaben

lässt sich eine generelle Aussage über die Qualität der Verbindung treffen. Die Qualitätsunterschiede

der Leitungen lassen sich aufzeigen, indem man den ping-Befehl für unterschiedliche Adressen ausführt.

Abbildung 4.10: Ergebnis des ping-Befehls unter Windows (Screenshot).

Tabelle 4.5: Ergebnisse des ping-Befehls (eigene Darstellung). Tabelle 4.5 zeigt eine kleine Auswahl an Internet-Adressen, für die ich zu Demonstrationszwecken den ping-Befehl durchgeführt habe. Anzumerken ist, dass es sich hierbei um kein repräsentatives Ergebnis handelt, denn je nach Datenaufkommen ergeben sich für ein und dieselbe Adresse innerhalb kurzer Zeitintervalle unterschiedliche Werte. Für eine statistische Auswertung müssten deshalb in jedem Fall Durchschnittswerte einer festgelegten Anzahl von ping-Durchläufen ermittelt werden. Zur Veranschaulichung der Arbeitsweise des Programmes soll diese einfache Übersicht jedoch genügen, bei der es nicht um Unterschiede von Millisekunden geht, sondern um das Aufzeigen der Bereiche, in denen sich die Werte bewegen. |

||||||||||||||||||||||||||||||

|

Die Einwahl erfolgte erneut von Freiburg im Breisgau aus. Eine erste Auswertung lässt den Schluss zu,

dass die Übertragungsdauer nicht proportional zur geographischen Entfernung wächst, wie das Verhältnis

der Zeiten von München und Los Angeles zeigen: Die Übertragungsgeschwindigkeit nach Los Angeles

verdoppelt sich lediglich, während die geographische Entfernung um ein Vielfaches ansteigt. Ebenso

beträgt die Übertragungsdauer nach Südafrika fast ein Dreifaches der Dauer nach Los Angeles, obwohl der

Zielort geographisch näher liegt. Als Konsequenz dieser Beobachtung kann die Schlussfolgerung

gezogen werden, dass der Ausbau der Internet-Infrastruktur für Geschwindigkeit und Qualität der

Datenübertragung eine entscheidendere Rolle spielt als geographische Entfernungen.

|

||||||||||||||||||||||||||||||

|

Programme, die auf der Funktion des Traceroute-Programmes basieren, wurden vor allem hinsichtlich ihrer

Benutzerfreundlichkeit und den Ausgabemöglichkeiten der Daten weiterentwickelt. Kennzeichen dafür sind

vor allem eine graphische Benutzeroberfläche und ein verstärkter Bezug zum physischen Raum, indem die

Lage der einzelnen Router in Karten und 3D-Modellen dargestellt wird. Das Programm NeoTrace der Firma

NeoWorx, Inc. (www.neoworx.com) bietet in dieser Hinsicht die Möglichkeit, zwischen vier verschiedenen

Ansichten zu wechseln. Neben der herkömmlichen Textausgabe gibt es die Möglichkeit, eine graphische

Übersicht der Router und der Übertragungsgeschwindigkeiten anzeigen zu lassen. Zusätzlich können

Informationen über einzelne Router, soweit verfügbar, in einem Pop-up Fenster angezeigt werden (siehe

Abbildung 4.11).

Von geographischem Interesse ist vor allem die Möglichkeit, die Übertragungsroute in der Kartenansicht zu betrachten. Für Abbildung 4.11 und 4.12 wurde als Beispiel erneut die Verbindung von Freiburg im Breisgau zum WWW-Server der Universität München verwendet. Das Ergebnis der ersten Routenverfolgung präsentierte in der Kartenausgabe ein zunächst etwas verwirrendes Ergebnis: Demnach befindet sich der Zielrechner der Universität München in der Nähe von Berlin (Abbildung 4.12). Eine diesbezügliche Anfrage beim Software Hersteller lieferte die Erklärung des Fehlers: Sofern die Koordinaten eines Zielrechners nicht in der Programmdatenbank aufgenommen sind, übernimmt NeoTrace nationale Standardkoordinaten, laut Hersteller entweder die Koordinaten der Hauptstadt oder des geographischen Zentrums eines Landes.

Abbildung 4.12: Kartenansicht des NeoTrace Programmes ohne Korrektur der Positionsangaben (Screenshot). Diese Methode wird allerdings nur bei unbekannten Zielrechnern angewandt, nicht bei unbekannten Routern, die auf dem Weg dorthin passiert werden. Da es aufgrund der schnell anwachsenden Zahl von Routern und Hostrechnern ohnehin nur schwer möglich ist, die Datenbank auf dem aktuellen Stand zu halten, verfügt das Programm über eine Aktualisierungsfunktion, mit der die Koordinaten eines bisher unbekannten Routers zugewiesen werden können. Unterstützend kann hierzu auf eine programminterne Datenbank zugegriffen werden, die die Koordinaten einer Vielzahl größerer Städte weltweit enthält. Die aktualisierten Daten können über das Internet zusätzlich an NeoWorx gesendet werden, um dort in die Datenbank aufgenommen zu werden. Mit den genannten Hilfsmitteln fällt es nicht schwer, die Koordinaten der Routing-Punkte für die Strecke Freiburg im Breisgau zur Universität München zu überarbeiten. Das Programm liefert nach der Aktualisierung eine korrekte Ausgabe, wie Abbildung 4.13 (Seite 78) zeigt. Auch die Online-Update-Funktion verläuft ohne Probleme: Nachdem die programminterne Aktualisierung beendet ist, öffnet sich ein WWW-Formular, das die geänderten Daten enthält und durch weitere Angaben über den Standort ergänzt werden kann.

Abbildung 4.13: Kartenansicht des NeoTrace Programmes nach Korrektur der Positionsangaben (Screenshot).

Abbildung 4.14: Kartenansicht des GeoBoy Programmes nach Korrektur der Positionsangaben (Screenshot). Wenn man die Wege der Internetdaten nicht nur vom heimischen Computer aus analysieren möchte, sondern auch Daten von fremden Rechnern aus ermitteln will, findet sich im WWW das Angebot sogenannter webserver traceroutes. Bei diesem Service wird der traceroute-Befehl vom angewählten Server ausgeführt und auf einer WWW Seite in der bereits vorgestellten Textform ausgegeben. Eine Zusammenstellung von Servern, die diesen Dienst weltweit bereitstellen, findet sich unter http://boardwatch.internet.com/traceroute.html. |

||||||||||||||||||||||||||||||

| (Anmerkung 2.1.2004: Die Übersichtsseite von internet.com ist nicht mehr verfügbar. Ersatz gibt es bei GeographyURL unter http://cities.lk.net/trlist.html.) | ||||||||||||||||||||||||||||||

|

Nachdem die Funktionsweise der Traceroute-Programme vorgestellt wurde, stellt sich die Frage, in

welcher Weise diese Programme für geographische Analysen genutzt werden können. Hier gilt es zu

berücksichtigen, dass neben der Möglichkeit, die Wege einzelner Datenpakete zu verfolgen, auch die

Gesamtheit des Datenaufkommens innerhalb eines Netzabschnittes gemessen werden kann. Forschungen, die

sich mit derlei Erhebungen beschäftigen und sie zusätzlich in einem geographischen Kontext darstellen,

sind momentan allerdings rar, da einige Faktoren die Recherche in diesem Bereich erschweren. Noch vor

wenigen Jahren war es vor allem die große Menge an Daten, die für derartige Forschungen zum

limitierenden Faktor wurde. Die heutzutage verfügbaren Rechnerleistungen ließen dieses Problem jedoch

weitgehend in den Hintergrund treten. Gravierender wirkt sich aus, dass es keine zentral verwalteten

Daten über den weltweiten Internetverkehr gibt. Seit der Privatisierung weiter Teile des Internet sind

Angaben zum Datendurchsatz einzelner Netze, vor allem auch aus Wettbewerbsgründen, nur selten zu

erhalten. Doch genau dieser Zugriff auf Routerstatistiken stellt momentan die einzige Möglichkeit dar,

um genaue Zahlen über das Datenaufkommen des Internet zu ermitteln. Wenn Daten in irgendeiner Form zu

dieser Thematik vorhanden sind, handelt es sich deshalb grundsätzlich nur um Ausschnitte des gesamten

Datenaufkommens oder um Schätzungen. Als Folge der fehlenden Datenbasis können vorhandene Daten oft

nicht für vergleichende Studien herangezogen werden, da sie entweder in unregelmäßigen Zeitintervallen

erfasst werden oder in anderer Weise nicht kompatibel sind. Forscher, die sich mit der Messung, bzw.

Darstellung des Internet-Datenaufkommens beschäftigt haben, stellen deswegen einstimmig fest, dass die

Schaffung einer homogenen Datenbasis die Grundlage für weiterführende Forschungen darstellt (CLAFFY,

1999).

|

||||||||||||||||||||||||||||||

|

Wenn trotz aller genannten Hindernisse Datensätze zumindest für einzelne Netze verfügbar sind, können

die Ströme des Datenverkehrs über eine Lokalisierung der Router, die am Transport der Datenpakete

beteiligt sind, in ihrem geographischen Kontext dargestellt werden. Bereits bei den

Traceroute-Programmen wurde auf die Schwierigkeit hingewiesen, aus den Angaben der Programme eine exakte

kartographische Darstellung zu erstellen, da für viele Router keine Koordinaten ermittelt werden konnten.

Abbildung 4.15 (Screenshot des VisualRoute Programmes, Seite 80) zeigt in den Fenstertiteln der

Detailansichten, dass sich das Programm sogenannter WHOIS-Abfragen bedient, um Informationen über

den betreffenden Router zu ermitteln. WHOIS-Datenbanken werden von den Domain-Registrierstellen

(wie die bereits erwähnte DENIC in Deutschland) bereitgestellt. Im VisualRoute Beispiel nutzt das

Programm die Datenbank der Reseaux IP Européens (RIPE), die europäische

Zentralstelle für die Vergabe von Domainnamen (http://www.ripe.net)

und die Datenbank des amerikanischen Pendants American Registry for Internet Numbers

(ARIN - http://www.arin.net). Diese Datenbanken können verwendet

werden, um den Eigentümer einer IP-Adresse zu ermitteln, der in der Regel mit Name und

(physisch-räumlicher) Adresse ausgegeben wird. Über die Adresse kann der Standort des Routers bestimmt

werden und somit sowohl in Traceroute-Programmen, als auch in Erhebungen über das Gesamtaufkommen des

Datenverkehrs, für eine kartographische Darstellung verwendet werden. Nicht immer verfügen die Programme

jedoch über eine ausgereifte Funktion, die von den Daten der WHOIS-Abfragen auf die korrekten

Koordinaten der Router schließen lässt - ein Manko, das für einen Großteil der beschriebenen Probleme

verantwortlich ist.

|

||||||||||||||||||||||||||||||

Sollten irgendwann in der Zukunft vollständig ausgewertete Datensätze über das Datenaufkommen und die

geographische Verortung des Internet vorliegen, bleibt als letzte Schwierigkeit die kartographische

Darstellung. Vor allem in globaler Hinsicht stößt man bereits zum jetzigen Zeitpunkt bei den noch

unvollständigen Daten über die Verortung von Datenursprung, Zielpunkten und der Datenmenge an die Grenzen

der Übersichtlichkeit. Eine Lösung bieten 3D-Modelle, in denen Verbindungen zwischen Routern in

Bogenform dargestellt werden, so dass zumindest einige der in 2D-Darstellungen überdeckten Wege sichtbar

werden. Abbildung 4.16 zeigt die Ansicht einer sogenannten arc map. Zur Orientierung dient im Original

zusätzlich zur Transparenz der Bögen eine unterschiedliche Farbgebung.

Abbildung 4.16: Datenaufkommen des Internet gemessen über einen Zeitraum von zwei Stunden. Teiltransparente Bogendarstellung (COX/EICK/HE, 1996).

Abbildung 4.17: Telekommunikationsdatenaufkommen über öffentliche Netzbetreiber in Europa 1997, Telegeography, Inc., 1997. Abbildung unter http://www.cybergeography.org/atlas/telegeography_large.gif |

||||||||||||||||||||||||||||||

In der Praxis sind die Gründe für unterschiedliche Auslastungen der Netzabschnitte vielschichtig.

Angefangen bei der allgemeinen Wirtschaftsstruktur eines Landes, über den Zustand der allgemeinen

Telekommunikations-Infrastruktur, bis hin zur Routingpolitik einzelner Netzbetreiber muss eine Vielzahl

von Faktoren berücksichtigt werden. Die Bedeutung des letztgenannten Punktes wird dann deutlich, wenn

man beispielsweise den Weg eines Datenpaketes von Deutschland nach Russland verfolgt. Hier wird nicht

die geographisch kürzeste Verbindung gewählt, sondern der Weg der am besten ausgebauten Infrastruktur.

Deshalb verläuft die untersuchte Route von Deutschland über Großbritannien und Schweden und von dort aus

nach Russland. Ein ähnliches Phänomen zeigt sich, wenn man den Weg von Daten aus Deutschland nach

Afrika verfolgt: Die erste Weiterleitung an einen Router außerhalb Deutschlands führt grundsätzlich in

ein Backbone-Netz der USA und erst von dort aus zum Ziel. Traceroute-Programme können in diesem

Zusammenhang dazu dienen, weltweite Datenströme zu entschlüsseln und die Anteile direkter Verbindungen

in ein Land oder eventuelle Transitanteile auszumachen.

Abbildung 4.18: Internet Weather Report des Matrix Information and Directory Services, Inc. (Screenshot der Seite http://www.mids.org/weather/world/20000501.html). |

||||||||||||||||||||||||||||||

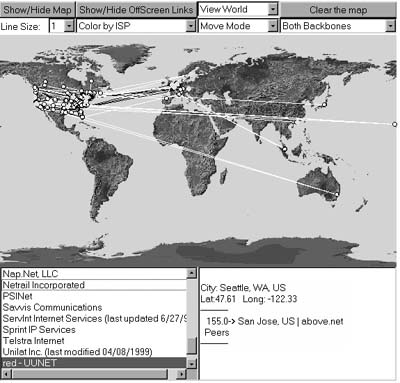

In sehr umfangreicher Weise beschäftigt sich auch die Cooperative Association for Internet Data

Analysis (CAIDA) in San Diego mit verschiedenen Aspekten des Internetdatenaufkommens. Neben

der Erörterung der grundsätzlichen Problematik, die bei der Erfassung der Internetdaten auftritt, stellt

CAIDA eine Vielzahl von Hilfsprogrammen bereit, die für Messung und Darstellung des Datenaufkommens

genutzt werden können. Als interaktive Webseite ist das Programm Webmap gestaltet, das die Möglichkeit

bietet, die Topologien verschiedener U.S. amerikanischer Netzwerkbetreiber kartographisch darzustellen

(siehe Abbildung 4.19). Dabei kann entweder ein einzelnes oder mehrere Netze zugleich dargestellt

werden. Im Fenster unter der Kartenausgabe werden für jeden Knotenpunkt Standort und Koordinaten

ausgegeben, für Verbindungen werden Bandbreite und Netzinhaber angezeigt.

Abbildung 4.19: Interaktive Mapnet-Webseite der CAIDA (Screenshot der Seite http://www.mids.org/weather/world/20000501.html). |

||||||||||||||||||||||||||||||

|

Zuletzt soll auf die Forschungen des Center for Advanced Spatial Analysis (CASA)

(http://www.casa.ucl.ac.uk/) der Universität London verwiesen werden, das es sich zum Ziel gemacht hat,

die Möglichkeiten der Informationstechnologie für Geographie, Raumplanung und Architektur zu ergründen.

Hier liegt der Ursprung des bereits mehrfach zitierten Atlas of Cyberspaces von Martin Dodge

(http://www.cybergeography.org), der mit die umfangreichste

Zusammenstellung an Möglichkeiten, das Internet zu kartieren, bereitstellt.

|

||||||||||||||||||||||||||||||

|

Mit der Übersicht über die Forschungseinrichtungen, die sich mit der Thematik des

Internet-Datenaufkommens beschäftigen, soll dieses Kapitel abgeschlossen werden. Zusammenfassend kann

festgehalten werden, dass Messungen des Internet-Datenaufkommens, aufgrund der momentan fehlenden

Datenbasis, nur in eingeschränktem Maße möglich sind. Trotzdem gibt es eine Vielzahl von Möglichkeiten,

aus partiellen Daten und sekundären Faktoren, wie der Ausstattung der physischen Infrastruktur,

Prognosen über die Verteilung des Internet-Datenaufkommens zu erstellen. Allerdings kann mit dieser

Methode im globalen Maßstab nur eine relative Verteilung der Datenströme ermittelt werden, eine absolute

Erfassung ist nicht möglich. Für kleinräumige Ermittlungen oder für Detailanalysen einzelner Netzwerke

stellen die Traceroute-Programme eine gute Möglichkeit dar, um Wege von Internetdaten im physischen Raum

zu lokalisieren.

Einleitung

1. Das Internet - Entstehung und technische Grundlagen 2. Die Zusammenhänge von Kulturgeographie und Internet 3. Die Analyse der physisch-räumlichen Komponenten des Internet 4. Das Internet und klassische Themenbereiche der Kulturgeographie 5. Ausblick 6. Anhang |